俗话说“外行看热闹,内行看门道“,作为一个机器学习的门外汉,刚研究python机器学习scikit-learn两周时间,虽然下面这段程序可能对于那些专研算法或机器学习的人来说非常简单,但对于一些入门的同学和我自己还是非常有帮助的。如果文章中有错误或不足之处,还请你微微一笑,原谅之;当然也非常欢迎你提出建议或指正~

基本步骤包括:

1.使用python+selenium分析dom结构爬取百度|互动百科文本摘要信息;

2.使用jieba结巴分词对文本进行中文分词,同时插入字典关于关键词;

3.scikit-learn对文本内容进行tfidf计算并构造N*M矩阵(N个文档 M个特征词);

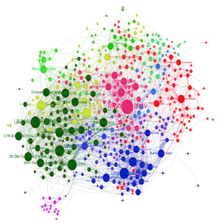

4.再使用K-means进行文本聚类(省略特征词过来降维过程);

5.最后对聚类的结果进行简单的文本处理,按类簇归类,也可以计算P/R/F特征值;

6.总结这篇论文及K-means的缺点及知识图谱的一些内容。

当然这只是一篇最最基础的文章,更高深的分类、聚类、LDA、SVM、随机森林等内容,自己以后慢慢学习吧!这篇作为在线笔记,路漫漫其修远兮,fighting~

基本步骤包括:

1.使用python+selenium分析dom结构爬取百度|互动百科文本摘要信息;

2.使用jieba结巴分词对文本进行中文分词,同时插入字典关于关键词;

3.scikit-learn对文本内容进行tfidf计算并构造N*M矩阵(N个文档 M个特征词);

4.再使用K-means进行文本聚类(省略特征词过来降维过程);

5.最后对聚类的结果进行简单的文本处理,按类簇归类,也可以计算P/R/F特征值;

6.总结这篇论文及K-means的缺点及知识图谱的一些内容。

当然这只是一篇最最基础的文章,更高深的分类、聚类、LDA、SVM、随机森林等内容,自己以后慢慢学习吧!这篇作为在线笔记,路漫漫其修远兮,fighting~

订阅专栏 解锁全文

订阅专栏 解锁全文

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?